G-Sync, FreeSync, V-Sync, Adaptive Sync : tout comprendre sur les technologies de rafraîchissement variable

G-Sync, FreeSync, Adaptive Sync, V-Sync, VRR : vous avez sans doute déjà entendu parler de ces technologies de rafraîchissement d’écran. Développées pour les joueurs ou professionnels de l’image, elles intéressent de plus en plus le grand public. Mais pourquoi ? Qu’apportent-elles vraiment ? On vous explique tout.

Pourquoi développer de telles technologies ?

À cette question, la réponse est souvent la même : les besoins. Avec le temps, les utilisateurs s’équipent de matériel de plus en plus performant. Aussi, la qualité des écrans doit suivre, et pas seulement au niveau de la qualité graphique. La fluidité et la vitesse de rafraîchissement figurent également parmi les principaux besoins des utilisateurs, notamment des joueurs. Parfois confrontés aux problèmes d’input lag, de stuttering ou encore de tearing, ils se tournent vers des moniteurs ou TV de plus en plus perfectionnés afin de mettre à profit tout leur talent (et éviter au passage de rager contre le matériel).

Pour répondre à leurs attentes, l’industrie a donc développé plusieurs technologies, souvent pour le meilleur, parfois pour le pire. Et si aujourd’hui de nombreux écrans sont susceptibles de se montrer à la hauteur des exigences de ce public, il est parfois difficile de s’y retrouver au milieu des appellations comme V-Sync, G-Sync, FreeSync ou Adaptive Sync.

V-Sync : le pied à l’étrier

Dans un premier temps, l’industrie a choisi de corriger les problèmes de tearing (ou screen tearing). Derrière ce terme se cache le phénomène de déchirement de l’image qui se produit lorsque le flux vidéo n’est pas synchronisé avec le taux de rafraîchissement de l’écran.

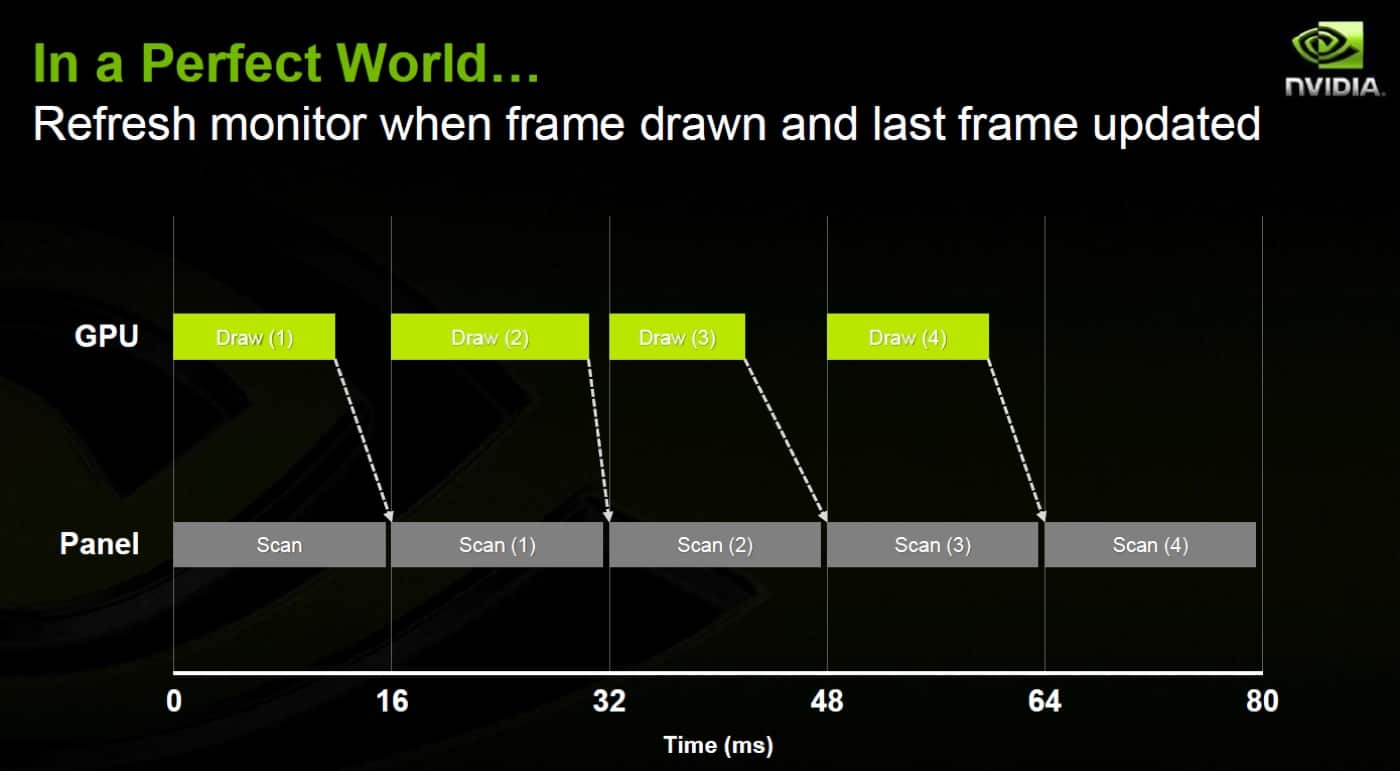

En résumé, le tearing apparaît lorsque la carte graphique et l’écran ne sont pas synchronisés. Un écran de 90 Hz par exemple interroge le GPU 90 fois par seconde avec une régularité aussi précise qu’une horloge suisse. De son côté, le GPU traite le volume de données de manière plus variable puisqu’il s’adapte aux mouvements de caméra, aux effets visuels, etc. La puissance de votre ordinateur entre donc en ligne de compte dans la fluidité de l’affichage.

Pour contourner ce phénomène, les constructeurs de cartes graphiques ont donc développé la technologie V-Sync. Grâce à elle, les GPU se synchronisent avec le taux de rafraîchissement de l’écran et évitent ainsi le problème de tearing.

Si V-Sync semblait s’imposer comme une solution miracle à son lancement, la technologie a très vite montré ses limites. En effet, si le tearing était de l’histoire ancienne, V-Sync ne corrigeait pas les problèmes d’input lag dûs aux retards de calcul du GPU ni celui du stuttering (micro-saccades affichant plusieurs fois la même image et réduisant donc l’impression de fluidité).

Nvidia et AMD ont alors tenté de corriger les faiblesses de V-Sync, le premier avec l’Adaptative V-Sync et la FastSync, le second avec l’Enhanced Sync. Insatisfaits des résultats, les deux principaux constructeurs de cartes graphiques se sont lancés dans une guerre pour gagner le cœur des joueurs.

G-Sync vs FreeSync : la guerre entre Nvidia et AMD

En 2013, Nvidia et AMD ont pris la décision d’abandonner la technologie V-Sync. Chacun a développé sa solution maison, le premier avec G-Sync, le second avec FreeSync. C’est la naissance du taux de rafraîchissement variable : désormais l’écran s’adapte en temps réel à ce que la carte graphique peut produire. Un tournant historique puisque les deux géants ont réussi à imposer leurs technologies aux fabricants de moniteurs et TV. Enfin presque… Car si techniquement G-Sync et FreeSync semblent réunir tout ce qu’attend un joueur, elles présentent tout de même un défaut : leur coût.

Fort de ses parts de marché sur le segment des cartes graphiques (autour des 80%), Nvidia a opté pour une technologie propriétaire. Problème : G-Sync repose sur une solution matérielle que les fabricants de moniteurs et TV doivent intégrer à leurs appareils. Le coût élevé que représente l’intégration de G-Sync a été répercuté sur le prix final des moniteurs et TV (logique). Pour le consommateur, l’écart de prix entre un écran FreeSync (AMD) et G-Sync était alors de l’ordre de 30% !

Pour justifier ce prix, Nvidia a joué la carte de la qualité premium. En effet, non seulement la certification G-Sync nécessite l’intégration d’un module propriétaire, mais les appareils compatibles doivent également réussir une batterie de tests (plus de 300) pour obtenir le Graal. Par ailleurs, le module G-Sync effectue plus de tâches que le FreeSync pour réduire le flou de mouvement (ou ghosting) et optimise les chutes de FPS, grosse faiblesse de la technologie d’AMD. En tout cas, à leurs débuts (nous y reviendrons).

Malgré les arguments mis en avant par Nvidia, les fabricants de moniteurs et TV n’ont pas vraiment mordu à l’hameçon. Aussi, ce serait un euphémisme de dire que le catalogue d’écrans FreeSync était bien plus fourni que celui de moniteurs G-Sync. Et cela s’explique par le choix technologique d’AMD.

FreeSync : AMD, l’autre école

Contrairement à Nvidia, AMD a misé sur une solution ne nécessitant pas d’ajout matériel. FreeSync repose sur un standard VESA Adaptive-Sync de 2009 visant à baisser la consommation d’énergie en réduisant la fréquence d’affichage si nécessaire. Bien qu’il utilise la technologie Adaptive Sync (intégrée à la norme DisplayPort 1.2a en 2014), AMD a choisi de conserver le nom commercial FreeSync pour désigner les moniteurs et TV compatibles avec l’Adaptive Sync. Vous suivez ? Tout cela pour dire que FreeSync ne demande qu’un support logiciel pour fonctionner sur n’importe quel écran compatible à condition d’utiliser un GPU Radeon.

À l’époque, ce choix technique permet à AMD de proposer une technologie d’écran répondant aux besoins des joueurs tout en limitant les coûts de fabrication (même s’ils restent plus élevés qu’un écran classique). Mais au fil du temps, les spécialistes et utilisateurs ont reconnu que la technologie G-Sync était plus performante que FreeSync, notamment – comme nous le disions plus haut – dans la gestion des baisses de FPS. Si AMD a par la suite annoncé le support du LFC (Low Framerate Compensation) pour corriger cette faiblesse, G-Sync restait tout de même un cran au-dessus. D’un côté Nvidia détenait donc la meilleure technologie, de l’autre AMD proposait une solution logicielle plus accessible permettant de démocratiser les moniteurs et TV du genre.

G-Sync Compatible : le meilleur des deux mondes

Après avoir amélioré chacun de leur côté leurs technologies (notamment avec l’adoption du HDR avec FreeSync 2 et G-Sync HDR), les deux géants ont trouvé un compromis, sous l’impulsion de Nvidia. En 2019, l’entreprise annonce que G-Sync va prendre en charge la norme VESA Adaptive-Sync, ce qui rime avec la fin de l’obligation d’intégrer le module G-Sync dans les moniteurs et TV. Une bénédiction pour les fabricants puisque les écrans FreeSync peuvent fonctionner avec des cartes graphiques Nvidia et donc G-Sync.

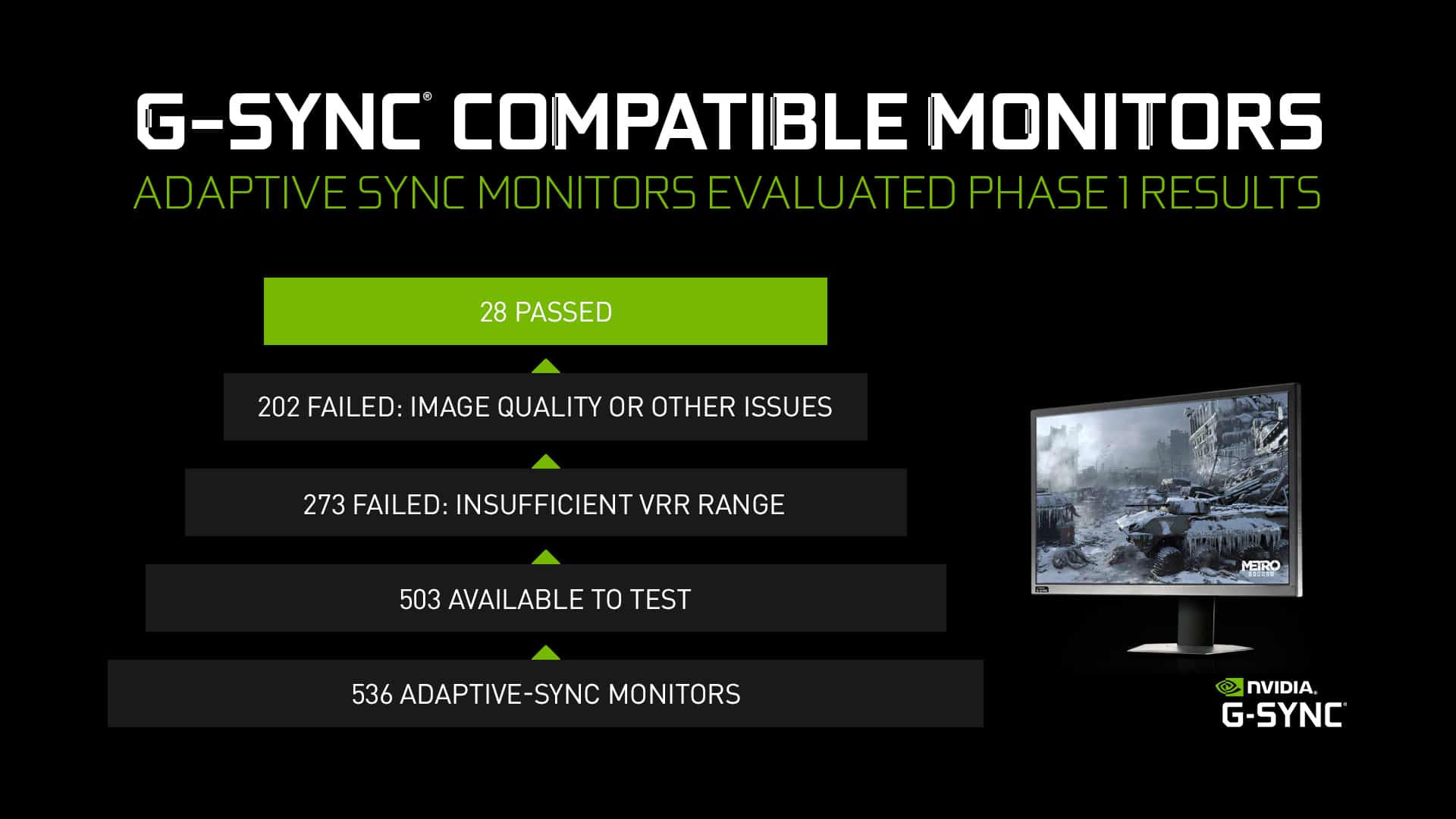

Pour indiquer les appareils compatibles, Nvidia a donc lancé la certification « G-Sync Compatible ». Le nombre d’écrans G-Sync est alors passé de 12 à 84 (G-Sync Compatible) depuis janvier 2019. Reste que les batteries de tests sur les appareils FreeSync demeurent compliquées. Le cahier des charges de Nvidia est très stricte (flickering, ghosting, pulsing etc.) et le constructeur impose une plage VRR (Variable Refresh Rate – Taux de rafraîchissement variable) de 2,4:1 minimum. De quoi donner du fil à retordre aux fabricants, mais pas à la décourager non plus, en témoigne le nombre grandissant d’écrans disponibles sur le marché.

G-Sync vs FreeSync : les nomenclatures

AMD et Nvidia déclinent leurs technologies G-Sync et FreeSync en trois « formules ». Ainsi chez Nvidia on trouve :

- G-Sync : solution matérielle. Les constructeurs doivent respecter un cahier des charges exigeant plus de 300 tests. Les modèles sont calibrés en usine.

- G-Sync Ultimate : offre la plus haut de gamme de Nvidia. Les écrans reprennent les atouts de G-Sync avec en prime une compatibilité HDR1000, un taux de rafraîchissement élevé, une excellente résolution, une plage colorimétrique complète comme le DCI-P3 et d’autres critères tout aussi exigeants.

- G-Sync Compatible : c’est la solution de Nvidia ne nécessitant pas l’intégration du module G-Sync. Pour répondre à ses critères, Nvidia exige une batterie de tests ainsi qu’une plage VRR d’au moins 2,4:1.

Chez AMD, FreeSync se décline aussi en trois versions :

- FreeSync : garantit une latence inférieure à 100 ms et supprime le tearing

- FreeSync Premium : reprend les exigences du FreeSync et ajoute la compatibilité LFC avec des écrans Full HD avec un taux de rafraîchissement de 120 Hz minimum.

- FreeSync Premium Pro : c’est la solution la plus premium d’AMD qui remplace FreeSync 2 HDR. En plus des exigences du FreeSync Premium, elle requiert une dalle Full HD 120 Hz, une compatibilité HDR400 et la compatibilité LFC ainsi qu’une faible latence en HDR et SDR.

Voilà, si vous êtes arrivés jusqu’ici alors vous devriez y voir plus clair dans cet océan de nouvelles technologies et normes. Peut-être avez-vous déjà craqué pour un moniteur ou une TV compatible FreeSync et/ou G-Sync. Dans ce cas, n’hésitez pas à nous livrer vos impressions.