Google révolutionne son outil de recherche Lens

Google Lens a introduit Multisearch, un nouveau système qui permet d’affiner vos recherches. L’idée est de combiner l’image et le texte pour vous aider à trouver l’objet que vous cherchez. Une nouvelle mise à jour qui, bien qu’elle soit anodine en apparence, devrait faciliter la vie de bon nombre d’utilisateurs.

Google Lens est une application aussi pratique que simple à utiliser. Disponible sur iOS et Android, elle permet de retrouver facilement sur le net un objet pris en photo. Toutefois, elle dispose d’une faiblesse que Google corrige dans une nouvelle mise à jour.

Cette mise à jour permet d’affiner la recherche à l’aide de texte. Expliqué ainsi, cela pourrait paraître un peu nébuleux, mais en pratique, Google promet un véritable changement en profondeur dans son application. Cela devrait faciliter la vie de bon nombre d’utilisateurs.

Google Lens se renforce avec Multisearch

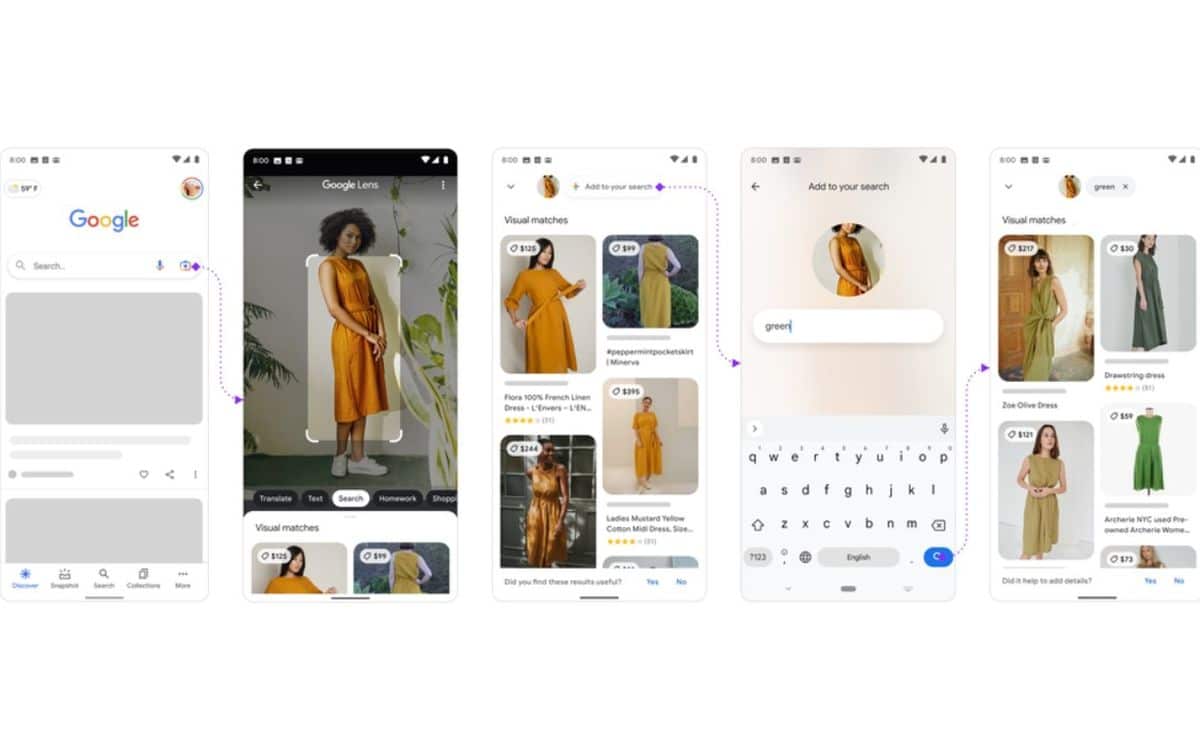

Pour expliquer le fonctionnement de sa mise à jour, la firme de Mountain View a pris des exemples concrets. Imaginons que vous preniez une robe orange en photo et que vous utilisiez Lens pour trouver le même modèle sur le net. L’application vous proposera, de base, la même robe orange. Avec multisearch, vous pourrez préciser que vous cherchez la même, mais en verte. L’IA vous proposera donc des résultats adaptés. Une solution idéale pour les accros du shopping.

D’autres usages sont possibles. Vous prenez en photo une table qui vous plaît et vous pouvez demander à Lens de trouver une table basse assortie. Plus encore, si l’utilisateur prend une plante en photo, il n’a qu’à taper « instruction pour l’entretien » dans Lens afin d’avoir tous les conseils adaptés pour garder sa plante en vie. Il ne s’agit là que des exemples de Google, mais on peut imaginer des milliers d’autres manières de se servir de ce multisearch.

Une modification discrète de Google Lens qui pourrait faire passer l’application de gadget sympathique à incontournable. La société mise beaucoup dessus à l’avenir afin d’articuler bon nombre d’usages autour. Pour le moment, cette fonctionnalité n’est disponible qu’en bêta et seuls les utilisateurs anglophones peuvent s’en servir. Pour le reste du monde, il faudra attendre un peu. Nous ne devrions pas en voir la couleur avant plusieurs semaines, voire plusieurs mois.

Source : Google